È uscito sulla rivista scientifica “PLOS ONE” l’articolo firmato dal prof. Giuseppe De Nicolao del Dipartimento di Ingegneria Industriale e dell’Informazione dell’Università di Pavia – cofirmatari Alberto Baccini ed Eugenio Petrovich dell’Università di Siena – dal titolo “Citation gaming induced by bibliometric evaluation: a country-level comparative analysis”, che getta luce sul “paradosso italiano” nell’ambito delle citazioni scientifiche.

Il paradosso italiano

Nel 2010, il sistema della ricerca italiano è stato profondamente ridisegnato dalla riforma dell’università introdotta con la legge Gelmini (L.240/2010). I fondi hanno subito tagli severi, accompagnati da una marcata riduzione del turn over e dall’introduzione di un complesso sistema di valutazione gestito dalla neonata Agenzia per la Valutazione della Ricerca e dell’Università (ANVUR). L’asse portante di questo sistema sono gli indicatori bibliometrici che, da quel momento, hanno iniziato a svolgere un ruolo fondamentale nell’accademia, in particolar modo nel reclutamento e nella promozione di ricercatori e professori. Ad oggi, superare le cosiddette “soglie bibliometriche”, che nei settori scientifici sono calcolate sulla base di citazioni, pubblicazioni e h-index, è condizione necessaria per ottenere l’Abilitazione Scientifica Nazionale (ASN).

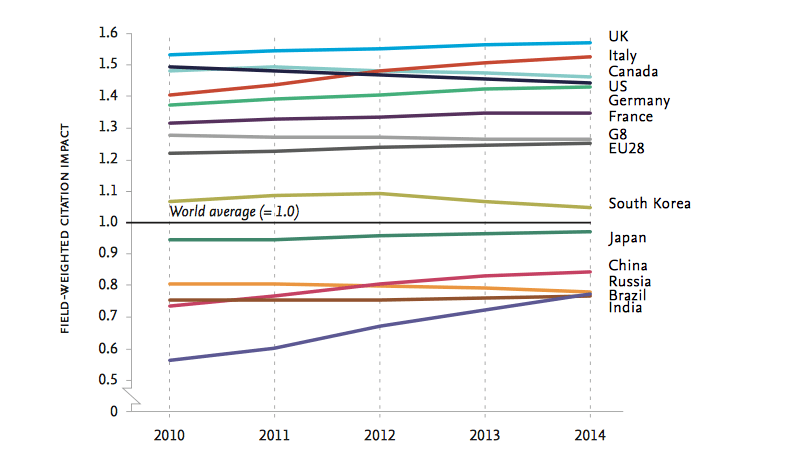

Ciò nonostante, negli anni post-riforma, a dispetto dei pesanti tagli ai finanziamenti e al personale, la ricerca italiana ha compiuto una specie di miracolo: il suo impatto, misurato in termini di citazioni e produttività, non solo non è diminuito, ma è addirittura aumentato. Nel 2012, in termini di impatto citazionale pesato (field-weighted citation impact), non solo le pubblicazioni italiane hanno superato quelle statunitensi, ma l’Italia è salita al secondo posto nella classifica dei Paesi G8, appena dietro al Regno Unito [i]. Di questo passo, secondo uno studio commissionato dal governo britannico l’Italia finirà per scalzare la Gran Bretagna dal primo posto [ii]. Anche Nature, in un recente editoriale, ha riconosciuto il continuo miglioramento della performance italiana, nonostante il basso livello di spesa pubblica in ricerca e sviluppo, ampiamente al di sotto della media europea [iii].

Tali risultati sembrano dimostrare che l’Italia sia diventata, grazie alla riforma, una vera e propria tigre della scienza europea. Tagli alla spesa, uniti al pervasivo uso di misurazioni bibliometriche, sembrerebbero la ricetta giusta per conquistare le vette dei ranking internazionali.

Eppure, prima di proporre la ricetta italiana come un modello vincente, esportabile in altri paesi europei o in Cina e India, vere potenze emergenti della scienza del XXI secolo, è opportuno gettare luce sul lato oscuro del successo italiano.

Una mascherata bibliometrica

Si moltiplicano gli studi che collegano l’uso massiccio della bibliometria nella valutazione della ricerca al diffondersi di comportamenti opportunistici, dovuti agli adattamenti strategici messi in atto dai ricercatori. In un recente studio, Ioannidis e i suoi collaboratori hanno rivelato che, tra i ricercatori che compaiono nella lista Clarivate dei più citati al mondo, ve ne sono diversi che fanno ricorso massiccio e sistematico all’autocitazione [iv]. In Italia, studi recenti hanno rilevato un aumento dell’uso strategico delle autocitazioni all’interno di alcuni settori scientifici [v].

Per la prima volta, lo studio [vi] mostra chiaramente che la recente impennata dell’impatto citazionale dell’Italia è essenzialmente un miraggio, prodotto da un cambiamento del comportamento citazionale dei ricercatori italiani dopo la riforma.

Per dimostrarlo, abbiamo ideato un semplice indicatore di auto-referenzialità della ricerca (Inwardness). Tale indicatore misura quale proporzione delle citazioni totali ricevute da un Paese provengano dal Paese stesso, cioè quanto dell’impatto totale di un Paese sia dovuto a citazioni “endogene”. In questo modo, l’indicatore è sensibile sia alle autocitazioni che ai cosiddetti “club citazionali” intranazionali – gruppi di ricercatori che si scambiano opportunisticamente citazioni tra di loro – in quanto entrambi i tipi di citazione provengono dal Paese stesso.

Confrontando gli andamenti nel tempo dell’Inwardness dei Paesi del G10, abbiamo osservato che, dopo il 2009, l’autoreferenzialità italiana compie un vero e proprio salto nella grande maggioranza dei settori di ricerca, distaccandosi nettamente dai trend degli altri membri del G10. Dietro gli USA, nel 2016 l’Italia diventa, sia globalmente sia maggior parte dei campi di ricerca, il Paese con il più alto indice di autoreferenzialità citazionale.

La spiegazione più probabile di questo fenomeno è che le nuove policy introdotte dalla riforma abbiano indotto nei ricercatori italiani un sostanziale incremento dell’uso strategico delle citazioni. La necessità di raggiungere gli obiettivi bibliometrici fissati da ANVUR ha creato un forte incentivo all’autocitazione e alla creazione di club citazionali. Tali comportamenti sono diventati così pervasivi da alterare sensibilmente e rapidamente il valore di Inwardness su scala nazionale, sia globalmente che nella maggior parte dei settori. L’incremento dell’impatto italiano registrato nei ranking risulta così essere il frutto di un doping citazionale collettivo. Dietro il miracolo italiano non ci sono politiche della scienza miracolose, ma una gigantesca mascherata bibliometrica.

Quale lezione trarre da tutto ciò? Qualcuno potrebbe pensare che per risolvere il problema potrebbero bastare interventi tecnici, come la rimozione delle autocitazioni dai calcoli o l’introduzione di indicatori più raffinati. In realtà, le soluzioni puramente tecniche sono destinate a fallire: i ricercatori sono estremamente veloci ad adattarsi ai cambiamenti delle regole del gioco e qualsiasi nuovo indicatore non farebbe altro che stimolare strategie di “gaming” ancora più raffinate e difficili da smascherare. Il vero insegnamento è che non esiste alcuna bacchetta magica – bibliometrica o di altro tipo – che possa gonfiare la performance scientifica di un Paese facendo leva su punizioni o incentivi legati all’uso meccanico di indicatori quantitativi.

Leggi l’articolo apparso su “Nature”: link

[i] Nature, Seven days: 6–12 December 2013, https://www.nature.com/news/seven-days-6-12-december-2013-1.14335

[ii] BIS, U. K. International Comparative Performance of the UK Research Base–2016. 2016, https://www.elsevier.com/research-intelligence/research-initiatives/beis2016

[iii] Nature, Editorial, ‘Memo to Italy’s president: your researchers need you’, 27 August 2019, https://www.nature.com/articles/d41586-019-02560-1

[iv] John P. A. Ioannidis et al., ‘A Standardized Citation Metrics Author Database Annotated for Scientific Field’, PLOS Biology17, no. 8 (12 August 2019): e3000384, https://doi.org/10.1371/journal.pbio.3000384.

[v] Marco Seeber et al., ‘Self-Citations as Strategic Response to the Use of Metrics for Career Decisions’, Research Policy48, no. 2 (March 2019): 478–91, https://doi.org/10.1016/j.respol.2017.12.004; Federico Scarpa, Vincenzo Bianco, and Luca A. Tagliafico, ‘The Impact of the National Assessment Exercises on Self-Citation Rate and Publication Venue: An Empirical Investigation on the Engineering Academic Sector in Italy’, Scientometrics117, no. 2 (November 2018): 997–1022, https://doi.org/10.1007/s11192-018-2913-5.

[vi] A. Baccini, G. De Nicolao, E. Petrovich, “Citation gaming induced by bibliometric evaluation: a country-level comparative analysis”, PLOSONE, 09.11.2019 https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0221212